Google Voice Search

Google er en av pionerene innen AI-forskning, og mange av deres prosjekter har fortsatt å snu hodet. AlphaZero fra Google DeepMind teamet var et gjennombrudd innen AI-forskning på grunn av programmets evne til å lære kompliserte spill av seg selv (Uten menneskelig trening og intervensjon). Google har også gjort et utmerket arbeid i Naturlige språkbehandlingsprogrammer (NLP), som er en av årsakene bak Google Assistents effektivitet i forståelse og behandling av menneskelig tale.

Google kunngjorde nylig utgivelsen av tre nye BRUK flerspråklige moduler og gi flere flerspråklige modeller for å hente semantisk lignende tekst.

De to første modulene gir flerspråklige modeller for å hente semantisk lignende tekst, den ene optimalisert for henting og den andre for hastighet og mindre minnebruk. Den tredje modellen er spesialisert for henting av spørsmålssvar på seksten språk (USE-QA) og representerer en helt ny bruk av USE. Alle de tre flerspråklige modulene er opplært ved hjelp av en multi-task dual-encoder rammeverk , ligner på den originale BRUK-modellen for engelsk, mens vi bruker teknikker vi utviklet for å forbedre dual-encoder med softmax-tilnærming med additiv margin . De er designet ikke bare for å opprettholde god ytelse for overføringslæring, men for å utføre veloppfylte semantiske gjenvinningsoppgaver.

Språkbehandling i systemer har kommet langt, fra grunnleggende syntaks-treparsering til store vektorforeningsmodeller. Forståelse av kontekst i tekst er et av de største problemene i NLP-feltet, og Universal Sentence Encoder løser dette ved å konvertere tekst i høydimensjonale vektorer, noe som gjør tekstrangering og betegnelse enklere.

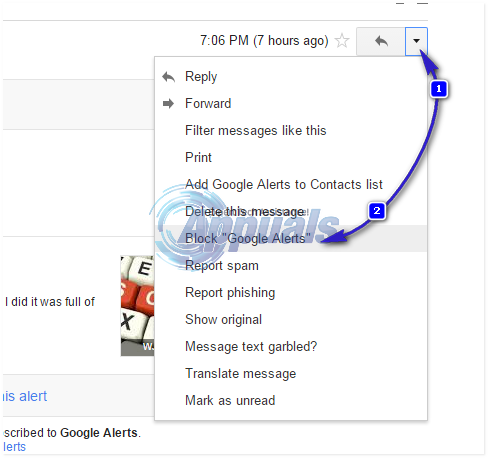

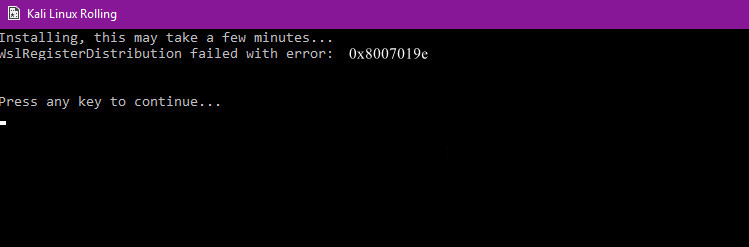

UTE Merking Structure Source - Google Blog

Ifølge Google, “ De tre nye modulene er alle bygget på semantisk gjenvinningsarkitektur, som vanligvis deler kodingen av spørsmål og svar i separate nevrale nettverk, noe som gjør det mulig å søke blant milliarder potensielle svar innen millisekunder. ”Dette hjelper med andre ord til bedre indeksering av data.

' Alle de tre flerspråklige modulene er opplært ved hjelp av en multi-task dual-encoder rammeverk , ligner på den originale BRUK-modellen for engelsk, mens vi bruker teknikker vi utviklet for å forbedre dual-encoder med softmax-tilnærming med additiv margin . De er designet ikke bare for å opprettholde god ytelse for overføringslæring, men for å utføre veloppfylte semantiske gjenvinningsoppgaver . ” Softmax-funksjonen brukes ofte til å spare beregningskraft ved å eksponere vektorer og deretter dele hvert element med summen av det eksponentielle.

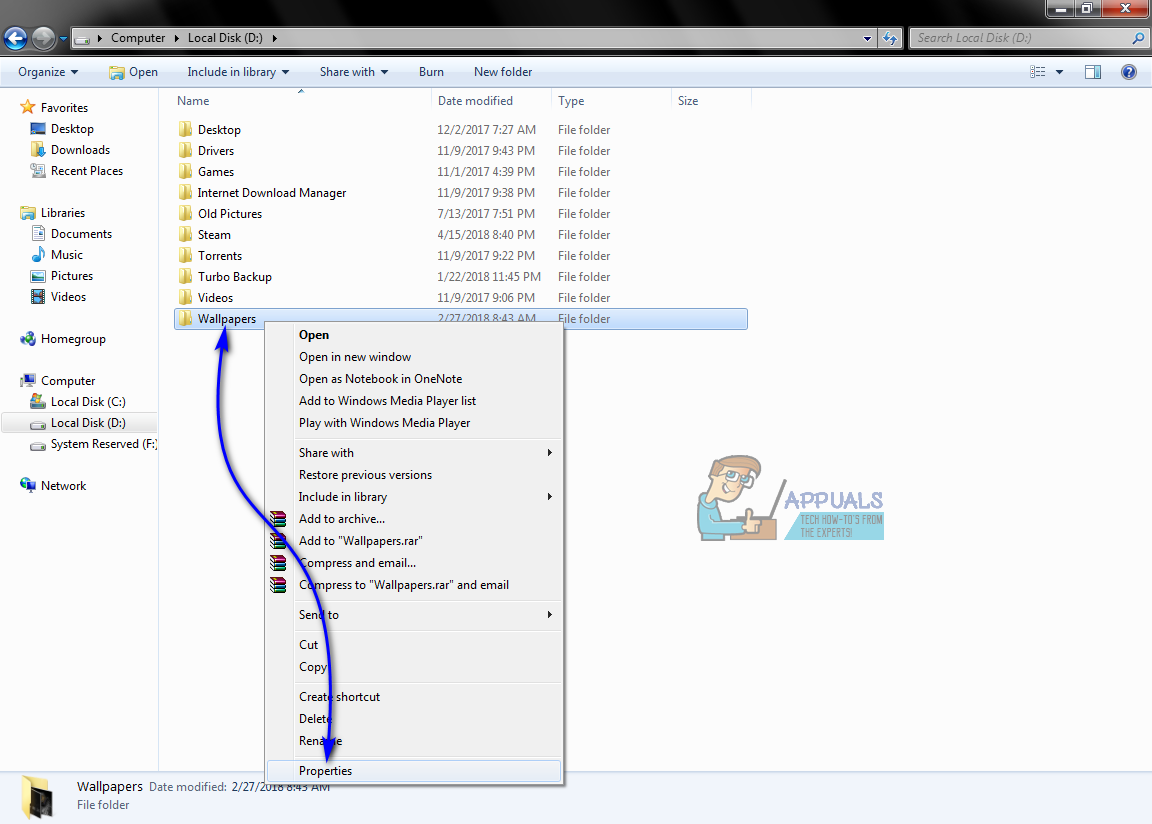

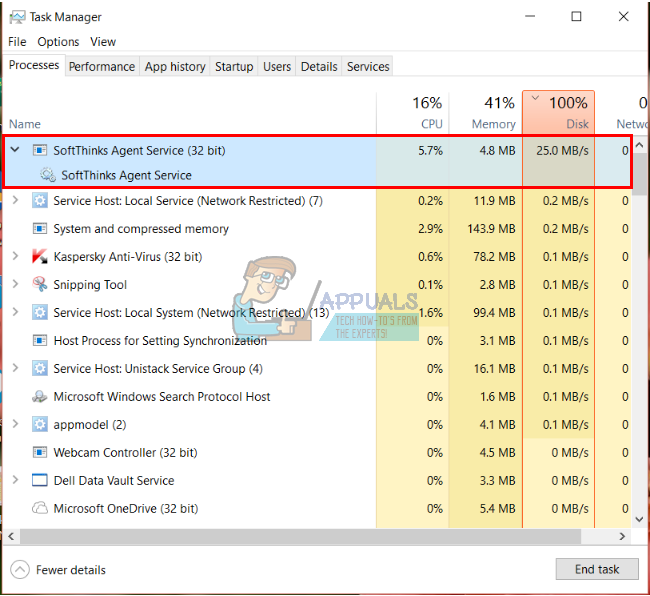

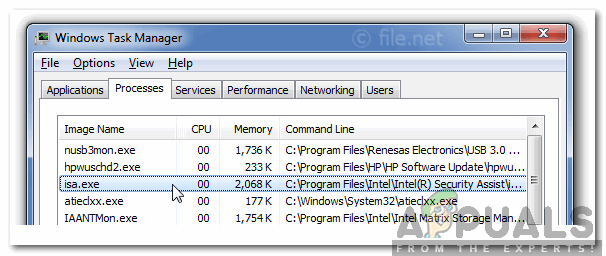

Semantisk gjenfinning arkitektur

“De tre nye modulene er alle bygget på semantiske gjenvinningsarkitekturer, som vanligvis deler kodingen av spørsmål og svar i separate nevrale nettverk, noe som gjør det mulig å søke blant milliarder potensielle svar innen millisekunder. Nøkkelen til å bruke doble kodere for effektiv semantisk gjenfinning er å forhåndskode alle kandidatsvar på forventede inngangsspørsmål og lagre dem i en vektordatabase som er optimalisert for å løse nærmeste naboproblem , som gjør det mulig å søke i et stort antall kandidater raskt med gode presisjon og tilbakekalling . '

Du kan laste ned disse modulene fra TensorFlow Hub. For videre lesing, se hele GoogleAI blogg innlegg .

Merker Google